Was ist menschengestütztes maschinelles Lernen? Bessere Daten und effektivere Modelle

Was ist menschengestütztes maschinelles Lernen? Bessere Daten und effektivere Modelle

Die menschliche und maschinelle Lernschleife verwendet menschliches Feedback, um Fehler in den Trainingsdaten zu beseitigen und die Genauigkeit des Modells zu erhöhen.

Modelle für maschinelles Lernen sind oft alles andere als perfekt. Wenn die Vorhersagen des Modells für Zwecke verwendet werden, die sich auf das Leben von Menschen auswirken, wie z. B. eine Kreditwürdigkeitsbewertung, wird einem Menschen empfohlen, zumindest einige der Vorhersagen zu überprüfen: diejenigen mit einem niedrigen Konfidenzniveau, diejenigen, die außerhalb des Bereichs liegen, und eine Qualitätskontrolle zufällige Probe.

Darüber hinaus erschwert der Mangel an gut gekennzeichneten (annotierten) Daten oft überwachtes Lernen (es sei denn, Sie sind ein Professor, bei dem Ihre Studenten nichts zu tun haben). Eine Möglichkeit, semi-überwachtes Lernen auf ungetaggten Daten zu implementieren, besteht darin, einige Daten für das Seeding von Modellen zu kennzeichnen, Vorhersagen mit hoher Zuverlässigkeit für das Zwischenmodell zu verwenden (oder Modelllernen zu übertragen), um mehr Daten zu markieren (Selbst-Tagging) und Vorhersagen zu senden über geringes Selbstvertrauen zu überprüfen Mensch (aktives Lernen). Der Prozess kann wiederholt werden und verbessert sich in der Praxis tendenziell von Übergang zu Übergang.

Überprüfen Sie auch:

Kurz gesagt, Human Loop Machine Learning ist auf menschliches Feedback angewiesen, um die Qualität der Daten zu verbessern, die zum Trainieren von Machine Learning-Modellen verwendet werden. Im Allgemeinen geht es beim menschlichen maschinellen Lernen darum, gute Daten zu erfassen, die ein Mensch markieren kann (Annotation), diese Daten zum Trainieren des Modells zu verwenden und das Modell zu verwenden, um weitere Daten für die Annotation zu erfassen. Es stehen viele Dienste zur Verwaltung dieses Prozesses zur Verfügung.

Amazon SageMaker Ground Truth

Amazon SageMaker bietet zwei Datenbeschreibungsdienste: Amazon SageMaker Ground Truth Plus und Amazon SageMaker Ground Truth. Beide Optionen identifizieren Rohdaten wie Bilder, Text und Videos und fügen Informationsetiketten hinzu, um qualitativ hochwertige Trainingsdatensätze für Modelle des maschinellen Lernens zu erstellen. Mit Ground Truth Plus richten Amazon-Experten Datenetiketten-Workflows für Sie ein, und dabei werden fortgeschrittenes Lernen und eine automatisierte Validierung der Etikettierung angewendet.

amazon erweiterte künstliche intelligenz

Während sich Amazon SageMaker Ground Truth mit der Vorklassifizierung von Daten befasst, bietet Amazon Augmented AI (Amazon A2I) eine menschliche Validierung von Vorhersagen mit geringem Vertrauen oder zufälligen Vorhersagestichproben aus implementierten Modellen. Erweiterte KI verwaltet sowohl die Erstellung des Review-Workflows als auch menschliche Reviewer. Integriert sich in AWS-KI- und maschinelle Lerndienste sowie Modelle, die auf dem Amazon SageMaker-Endpunkt bereitgestellt werden.

DataRobot – Mensch im Ring

DataRobot verfügt über eine bescheidene KI-Funktion, mit der Sie Regeln festlegen können, um unsichere Vorhersagen, externe Eingaben und Bereiche mit geringer Überwachung zu erkennen. Diese Regeln können zu drei möglichen Aktionen führen: keine Aktion (nur Überwachung); die Vorhersage ungültig machen (normalerweise mit einem „sicheren“ Wert); oder einen Fehler zurückgeben (die Vorhersage ablehnen). DataRobot hat eine Dokumentation über Human in the Loop geschrieben, aber ich konnte auf ihrer Website keine andere Implementierung als die Regeln der Demut finden.

Google Cloud Human-in-the-Loop

Google Cloud bietet Human-in-the-Loop (HITL)-Verarbeitung, die in seine Document AI-Dienste integriert ist, aber wie in diesem Artikel, nichts für die Bild- oder Videoverarbeitung. Derzeit unterstützt Google HITL-Überprüfungsworkflows für die folgenden Prozessoren:

Auftragsverarbeiter:

Rechnungen

Quittungen

Kreditverarbeiter:

1003 Analytiker

1040 Parser

1040 Analysegerät Tabelle C

1040 Tabelle E Parser

1099-DIV-Analysator

1099-G-Analysator

1099-INT Analysator

1099-MISC-Analysator

Kontoauszugsanalyst

Analysierte Aussage von HOA Analyst

Hypothekenextrakt-Analysator

Pay-Coupon-Analysator

Ruhestandsanalyst / Anlageerklärung

W2 محلل Analysator

W9-Parser

menschliche Dienstleistungsprogramme

Es kann schwierig sein, menschliche Bildanmerkungen wie Bildklassifizierung, Objekterkennung und semantische Segmentierung zu konfigurieren, um Datensätze zu kennzeichnen. Glücklicherweise gibt es viele gute kommerzielle und Open-Source-Tools, die Labeler verwenden können.

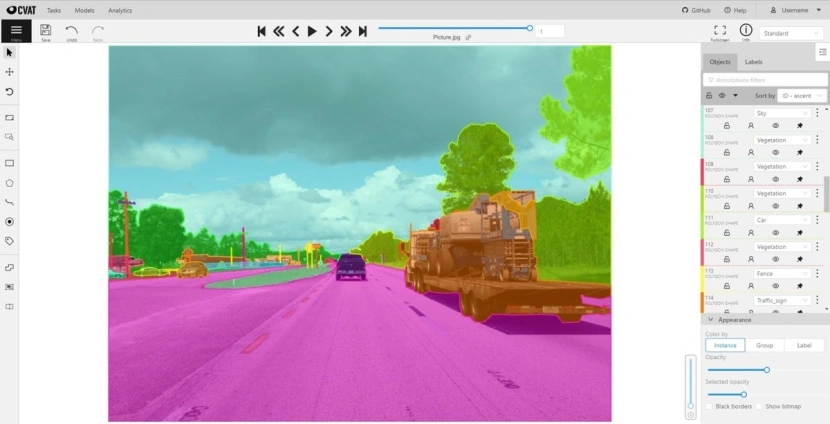

Humans in the Loop, ein Unternehmen, das sich selbst als „soziales Unternehmen beschreibt, das ethische Personallösungen liefert, um die KI-Branche voranzutreiben“, bloggt regelmäßig über seine bevorzugten Anmerkungstools. In ihren neuesten Einträgen haben sie 10 Open-Source-Computer-Vision-Annotationstools aufgelistet: Label Studio, Diffgram, LabelImg, CVAT, ImageTagger, LabelMe, VIA, Make Sense, COCO Annotator und DataTurks. Diese Tools werden häufig verwendet, um Trainingssätze zu kommentieren, und einige können Anmerkungssätze verwalten.

Beispielsweise ist das Computer Vision Annotation Tool (CVAT) leistungsstark, aktuell und funktioniert in Chrome. Es ist nach wie vor eines der wichtigsten Tools, die wir und unsere Kunden für die Etikettierung verwenden, da es viel schneller ist als viele Tools auf dem Markt.“

CVAT README auf GitHub schreibt: „CVAT ist ein kostenloses webbasiertes interaktives Bild- und Videoannotationstool für Computer Vision. Es wird von unserem Team verwendet, um Millionen von Objekten mit unterschiedlichen Eigenschaften zu kommentieren. Viele Entscheidungen über Benutzeroberflächen und Benutzererfahrungen basieren auf Feedback von professionellen Datenannotationsteams. Probieren Sie es online unter cvat.org aus.“ Zum Ausführen der Demo muss ein Login erstellt werden.

CVAT wird als Open Source unter der MIT-Lizenz veröffentlicht. Die meisten aktiven Schuldner von Intel sind in Nischni Nowgorod, Russland, tätig. Das CVAT-Einführungsvideo zeigt, wie der Kennzeichnungsprozess funktioniert.

Wie Sie sehen können, kann die menschliche Schleifenverarbeitung an zwei Stellen zum maschinellen Lernprozess beitragen: die anfängliche Erstellung von Datensätzen, die für überwachtes Lernen gekennzeichnet sind, und die Überprüfung und Korrektur potenziell problematischer Vorhersagen, wenn das Modell ausgeführt wird. Der erste Anwendungsfall hilft, das Modell zu glätten, und der zweite Fall hilft, das Modell festzulegen.

Quelle: InfoWelt